Miniaturizacion

Se denomina miniaturización

al proceso tecnológico mediante el cual se intenta reducir el tamaño de los

dispositivos electrónicos.

Historia

Las primeras radios y otros dispositivos electrónicos dependían de la tecnología de los tubos de vacío. Como los tubos ocupaban mucho espacio, los aparatos que los empleaban solían ser muy voluminosos y pesados. A finales de los años 1940, el desarrollo del transistor ofreció una alternativa compacta a los tubos de vacío.

Los

transistores podían lograr el mismo nivel de amplificación de potencia lograda mediante tubos, al tiempo

que ocupaban mucho menos espacio y usaban sólo una pequeña fracción de la energía. A partir de los años 1960, el circuito integrado proporcionó otro nivel adicional de

miniaturización.

Un circuito integrado del tamaño

de un transistor podía realizar la función de veinte transistores. Hoy en día,

el microprocesador, una mejora moderna de los circuitos integrados

originales, puede incorporar las funciones de varias placas completas de

circuitos impresos en un solo chip de bajo consumo eléctrico y que

ocupa menos de trece centímetros cuadrados, posibilitando la fabricación de ordenadores portátiles más potentes que los enormes ordenadores centrales

usados en las décadas de 1970 y 1980 espectivamente.

Una de las tendencias actuales en muchas áreas del conocimiento está

dirigida hacia la miniaturización, automatización y simplificación.

La miniaturización de los sistemas analíticos tiene

por objeto la reducción del tamaño de los dispositivos de análisis incluyendo

en los mismos todas las operaciones clásicas de pretratamiento (filtración,

extracción, etc.…), mezcla, reacción, preconcentración, separación y detección.

Esto ha dado lugar a los llamados “Lab-on-a-Chip” (LOC) o los microsistemas de

análisis total (µTAS).

Algunas de las ventajas del empleo de sistemas

miniaturizados son: reducción en el consumo de muestra y reactivos, disminución

de los desechos, lo cual permite realizar diagnósticos médicos a partir de una

simple gota de sangre o el desarrollo de sensores “in-vivo”. Además,

normalmente se acortan los tiempos de análisis y se pueden integrar diversos

ensayos en un mismo sistema sin aumentar su complejidad, así como automatizar

distintos procedimientos analíticos.

Entre los diferentes microsistemas

descritos, destacan los microchips de electroforeis (ME).

Una de las tendencias actuales en muchas áreas del

conocimiento está dirigida hacia la miniaturización, automatización y

simplificación.

La miniaturización de los sistemas analíticos tiene

por objeto la reducción del tamaño de los dispositivos de análisis incluyendo

en los mismos todas las operaciones clásicas de pretratamiento (filtración,

extracción, etc.…), mezcla, reacción, preconcentración, separación y detección.

Esto ha dado lugar a los llamados “Lab-on-a-Chip” (LOC) o los microsistemas de

análisis total (µTAS).

Algunas de las ventajas del empleo de sistemas

miniaturizados son: reducción en el consumo de muestra y reactivos, disminución

de los desechos, lo cual permite realizar diagnósticos médicos a partir de una

simple gota de sangre o el desarrollo de sensores “in-vivo”. Además,

normalmente se acortan los tiempos de análisis y se pueden integrar diversos

ensayos en un mismo sistema sin aumentar su complejidad, así como automatizar

distintos procedimientos analíticos.

Entre los diferentes microsistemas descritos, destacan

los microchips de electroforeis (ME).

Actualmente, la mayor parte de los elementos

electrónicos se pueden miniaturizar. Sin embargo, los elementos ópticos de

muchos de los sistemas de detección empleados son, hoy por hoy, dificiles de

miniaturizar sin perdida de prestaciones. En este punto los sistemas de

detección electroquímicos son facilmente miniaturizables sin perdida de

sensibilidad e incluso mejorando la relación señal/ruido.

“Estamos ante chips al límite de su miniaturización”

Carver

Mead, ingeniero electrónico estadounidense, gana el Premio Fundación BBVA

Fronteras del Conocimiento por su aportación al desarrollo de las tecnologías

de la comunicación

·

Donald E.

Knuth gana el Premio Fronteras del Conocimiento 2011

·

Carver Mead, galardonado con el

Premio Fronteras del Conocimiento. / FUNDACIÓN BBVA

“En los años setenta la gente no creía que

los chips pudieran hacerse pequeños”, ha dicho Carver Mead tras conocer que

había ganado el Premio Fundación BBVA Fronteras del Conocimiento en la

categoría de Tecnologías de la Comunicación, que ha sido comunicado hoy. El

ingeniero fue el primero en predecir, en aquella época, que los chips

integrarían millones de transistores. El primero, inventado por Jack Kilvy en

1958, tenía solo uno. Hoy, el pronóstico de Mead es una realidad gracias a la

tecnología del silicio que él mismo contribuyó a desarrollar. Los chips

contienen cada vez más información en un espacio más pequeño. El galardonado ha

señalado hoy durante el anuncio de este premio que “ya estamos casi al límite

de la miniaturización de los chips de tan pequeños que han llegado a ser”. Pero

ha señalado que se buscan nuevos materiales. “Hay gente que inventa mucho”, ha

dicho. En ese sentido, el pasado 12 de enero IBM anunciaba que científicos de

la empresa y del Centro Alemán para las Ciencias de Láser de Electrones Libres

(CFEL) han construido la unidad magnética de almacenamiento

de datos mas pequeña del mundo, con capacidad de almacenar cien vece

CHIP

Nanotubos de carbono, hacía la

miniaturizacion de circuitos integrados

Justo cuando

parecía que los microchips no podían ser más pequeños, y la carrera

por la miniaturización limitada por barreras físicas insuperables, una

técnica desarrollada por investigadores del departamento de ingeniería

de la Universidad de Cambridge promete dar lugar a circuitos integrados

que no sólo son más pequeños sino que pueden soportar densidades de corriente

eléctrica cinco veces mayores que la tecnología actual.

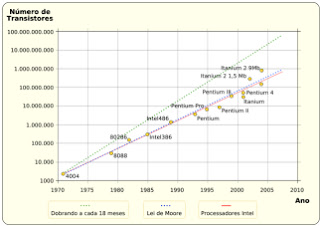

Esta ley empírica formulada en 1965 sostenía que

aproximadamente cada 18 meses se duplica el número de transistores

en un circuito integrado. En 1975 Moore le introdujo una modificación, y

planteo que esto ocurriría cada 24 meses. A pesar de que cuando

se formuló no existían los microprocesadores (1971) ni

los ordenadores personales (década de los 80), sus enunciados han servido

de guía para la industria hasta el día de hoy.

Sin embargo

en los últimos años los expertos de este campo comenzaron a preocuparse

respecto a las posibilidades de poder seguir manteniendo un ritmo de desarrollo

tan acelerado. Los obstáculos que aparecían en el futuro

eran varios: por un lado el aumento del consumo de energía con su consecuente aumento en

la generación de calor y el peligro que ello conlleva para la vida útil de los circuitos, por otro la imposibilidad

de pasar más allá de cierta escala en la cual los electrones

comienzan a saltar de una vía a otra sin respetar los trazados del

circuito.

El problema

era tal que comenzaron a surgir distintas criticas y planteos, que junto con la

necesidad de desarrollar diferentes tipos de procesadores como alternativa a los actuales, dio origen a

desarrollos novedosos como el de procesadores basados en ADN. Los mas críticos sostenían que no

tenia ningún sentido seguir intentando concentrar cada vez mas

circuitos y energía en espacios cada vez más pequeños, y lo necesario no era un

nuevo desarrollo nanotecnológico que permitiera atravesar ese umbral que

comenzaba a vislumbrarse a lo lejos, sino un cambio rotundo en la manera que

tenemos de pensar los procesadores, un giro copernicano en nuestra

forma de entender la computación actual.

Pues bien,

justo cuando ese umbral parecía ya estar demasiado cerca, una

nueva tecnología acaba de hacerlo desaparecer del horizonte de

la computación una vez más, aunque sea por un tiempo. El profesor John Robertson y

Santiago Esconjauregui han desarrollado una técnica que

permite remplazar el cobre hasta ahora utilizado para conducir la electricidad

en los circuitos integrados por nanotubos de carbono.

Los nanotubos

de carbono consisten en un ordenamiento especial de los átomos de

carbono. Normalmente, por ejemplo en el grafito, los átomos

se disponen de manera hexagonal y se ordenan en capas formando hojas o

planchas. En los nanotubos estas

capas son enrolladas formado tubos muy diminutos, de un diámetro equivalente a

unos pocos átomos de carbono. Estos nanotubos de carbono pueden soportar

altas densidades de corriente eléctrica, lo que los transforma en excelentes

candidatos para sustituir al cobre en los circuitos integrados.

La miniaturización de

los componentes de los circuitos integrados, ha obligado a una

miniaturización proporcional de los hilos conductores de cobre que conectan a

estos componentes, se ha ido aumentando así la densidad de

corriente eléctrica que el cobre debe trasportar llegándose a un punto

donde será necesario transportar más energía que la que esa cantidad

de cobre puede transportar.

Para que sea

factible sustituir el cobre por nanotubos de carbono, estos deben ordenarse en

paquetes de muy alta densidad, lo cual no era posible hasta ahora.

Sin esta densidad, la cantidad de corriente que se puede conducir

a través de los nanotubos no es suficiente.

Los nanotubos de carbono se cultivan depositando una fina película de un catalizador, como el hierro, sobre un sustrato, luego se cambiaban las propiedades del catalizador a través del uso de calor, lo cual genera una serie de nanopartículas que son la base para el crecimiento de cada nanotubo. Este proceso da como resultado paquetes de nanotubos, pero de una densidad muy baja que no permiten la conducción de electricidad necesaria.

Los nanotubos de carbono se cultivan depositando una fina película de un catalizador, como el hierro, sobre un sustrato, luego se cambiaban las propiedades del catalizador a través del uso de calor, lo cual genera una serie de nanopartículas que son la base para el crecimiento de cada nanotubo. Este proceso da como resultado paquetes de nanotubos, pero de una densidad muy baja que no permiten la conducción de electricidad necesaria.

El profesor

Robertson y sus colegas han ideado un método para el cultivo de paquetes de

nanotubos a través de la repetición en múltiples pasos del mecanismo

anterior, resultando en aumentos sucesivos de la densidad de las

nanopartículas. Los paquetes resultantes tienen una densidad que es cinco

veces mayor que la obtenida hasta ahora, lo cual permite conducir

una densidad de corriente eléctrica cinco veces mayores que la tecnología

actual. Quedando abierta la posibilidad de aumentar cada vez mas esta densidad

en el futuro.

Se

abren así nuevas oportunidades para continuar con la miniaturización

de los microchips de nuestros ordenadores, celulares, pads,

y gadgets. A la vez que se evita un cambio

radical en la forma de fabricación que pudiera implicar una baja en la tasa

actual de implementación tecnológica. Una vez más la Ley de Moore no solo ha

demostrado su funcionalidad, sino que ha logrado superar un escollo grave que

amenazaba con dejarla en desuso. La única mala noticia de esto es que nuestros

dispositivos continuaran perdiendo rápidamente su valor a la razón de un 50% al

año.

Desde que en 1975 Gordon E. Moore modificara parte de los enunciados de lo que hoy conocemos como Ley de Moore, la industria de la circuitos integrados y los microprocesadores ha venido cumpliendo a rajatabla con la misma.

No hay comentarios:

Publicar un comentario